C114讯2月26日消息(赵婷婷)随着5G网络的普及与边缘计算技术的飞速发展,终端侧AI的应用场景愈发广泛,不仅降低了数据传输过程中的时延问题,还确保了数据在本地处理的安全性和私密性。如今,终端侧AI的商用进程已经开始。

2月26日,2024年世界移动通信大会(以下简称MWC2024)在西班牙巴塞罗那正式拉开帷幕。作为通信和AI技术的领军企业,高通宣布推出全新的高通AI Hub,为开发者打造获取开发资源的中心,从而基于骁龙或高通平台打造AI应用。

高通AI Hub提供全面优化的AI模型库支持

高通技术公司产品市场高级总监Ignacio Contreras指出,终端侧AI已经到来,终端侧AI能够为用户带来即时性、可靠性、隐私以及个性化等诸多优势。当前需要为开发者提供更多的支持,赋能其打造全新的、令人期待的应用。高通AI Hub为开发者提供全面优化的AI模型库支持,包括传统AI模型和生成式AI模型,能够跨骁龙和高通平台部署。

具体而言,开发者只需选择应用所需的模型(例如Baichuan-7B),以及其开发应用所使用的框架(例如Pytorch、Tensorflow),之后确定目标平台,例如一款特定型号的手机、或者一款特定型号的高通平台(例如第三代骁龙8),高通AI Hub就可以为开发者提供面向其指定应用、指定平台进行优化的模型。

“开发者只需要几行代码就可以获取模型,并将模型集成进应用程序。”Ignacio Contreras说道。

与此同时,高通AI Hub将支持超过75个AI模型,包括传统AI模型和生成式AI模型。通过对这些模型进行优化,开发者运行AI推理的速度将提升高达4倍。不仅是速度提升,优化后的模型占用的内存带宽和存储空间也将减少,从而实现更高的能效和更持久的电池续航。

“这些优化模型将在高通AI Hub、以及HuggingFace和GitHub上提供,让开发者能够将AI模型便捷地集成到工作流中。”

展示多款“首个”多模态大模型

此次MWC2024,除发布高通AI Hub之外,高通还展示了多款“首个”多模态大模型。

据Ignacio Contreras介绍,高通展示了全球首个在搭载第三代骁龙8的Android手机上运行的多模态大模型,此次演示中这个超过70亿参数的LMM,可支持文本、语音和图像输入,能基于输入的内容及时响应,进行多轮对话,并且更好地保护隐私。

高通还在搭载全新骁龙X Elite平台的Windows PC上,带来另一个多模态AI的演示。据介绍,这是全球首个在Windows PC上运行的音频推理多模态大模型,它能理解鸟鸣、音乐或家中的不同声音,并且能够基于这些信息进行对话,为用户提供帮助。

另外,高通首个在Android手机上运行的LoRA模型能够在不改变底层模型的前提下,调整或定制模型的生成内容。通过使用很小的适配器(大小仅为模型的2%,便于下载),个性化定制整个生成式AI模型的行为,可根据不同个人或艺术偏好创建高质量自定义图像。

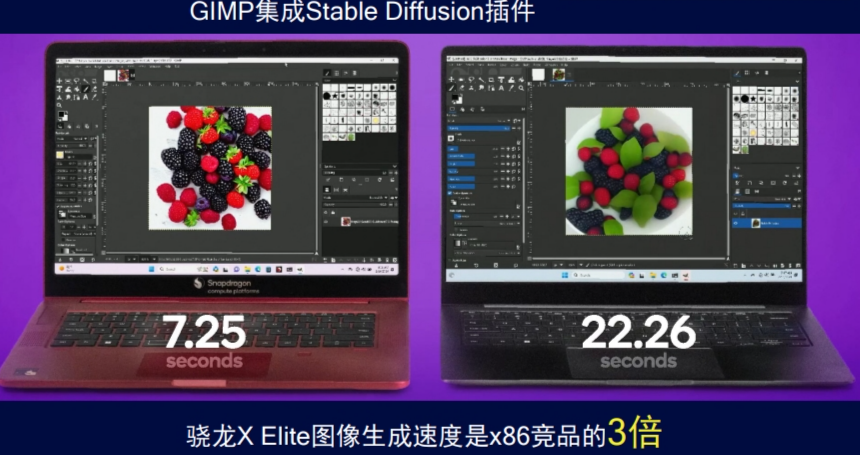

不仅如此,Ignacio Contreras还表示,骁龙X Elite图像生成速度是x86竞品的3倍。使用分别搭载骁龙X Elite和搭载市场中常见X86芯片的两台笔记本电脑进行对比,并同时运行集成Stable Diffusion插件的GIMP(一款广受欢迎的图像编辑器)进行AI图像生成。骁龙X Elite只需7.25秒就能生成一张图像,速度是X86竞品(22.26秒)的3倍。骁龙X Elite的NPU运算能力高达45TOPS,大幅领先于竞品。