使用人工智能(AI)可以降低设计成本,提高产量和性能,缩短产品上市时间,从而获得更好的芯片。新思科技(Synopsys)、楷登电子(Cadence Design Systems)和许多超大规模芯片设计公司目前正在采用生成式AI来推动芯片设计。我们可以将其视为电子设计自动化(EDA)的第二代人工智能。而这将带来什么变革?

每个芯片都需要经过一系列设计和测试应用,这些应用通常来自EDA供应商,如Synopsys和Cadence。几年前,Synopsys率先应用人工智能,推出了名为DSO.ai的工具,帮助芯片设计团队评估约109万种潜在的设计方案,每种方案都可能产生不同功耗、性能和成本的芯片。DSO.ai和它的主要竞品Cadence Cerebrus可以节省大量的工程时间,能够将后端流程从数月缩短到数周,参与人员从一个完整的团队缩减到一两个工程师。多家公司都表示,有数百家客户使用了他们的AI工具,并获得了客观收益,而如今人工智能在芯片设计领域的应用有了更多进展。

有什么变化?

最近一段时间,EDA市场不断发展,以利用生成式人工智能来改进工作流程。此前从物理布局到设计验证,再到测试和制造,业界已经将有效的老式人工智能(GOFAI)应用到了各个方面。许多供应商称这种人工智能为生成式人工智能,这为协助工程团队开辟了新的途径,但它并非基于大型语言模型(LLM),LLM不会取代现有的EDA人工智能。

那么,AI是如何帮助芯片设计人员呢?

Synopsys

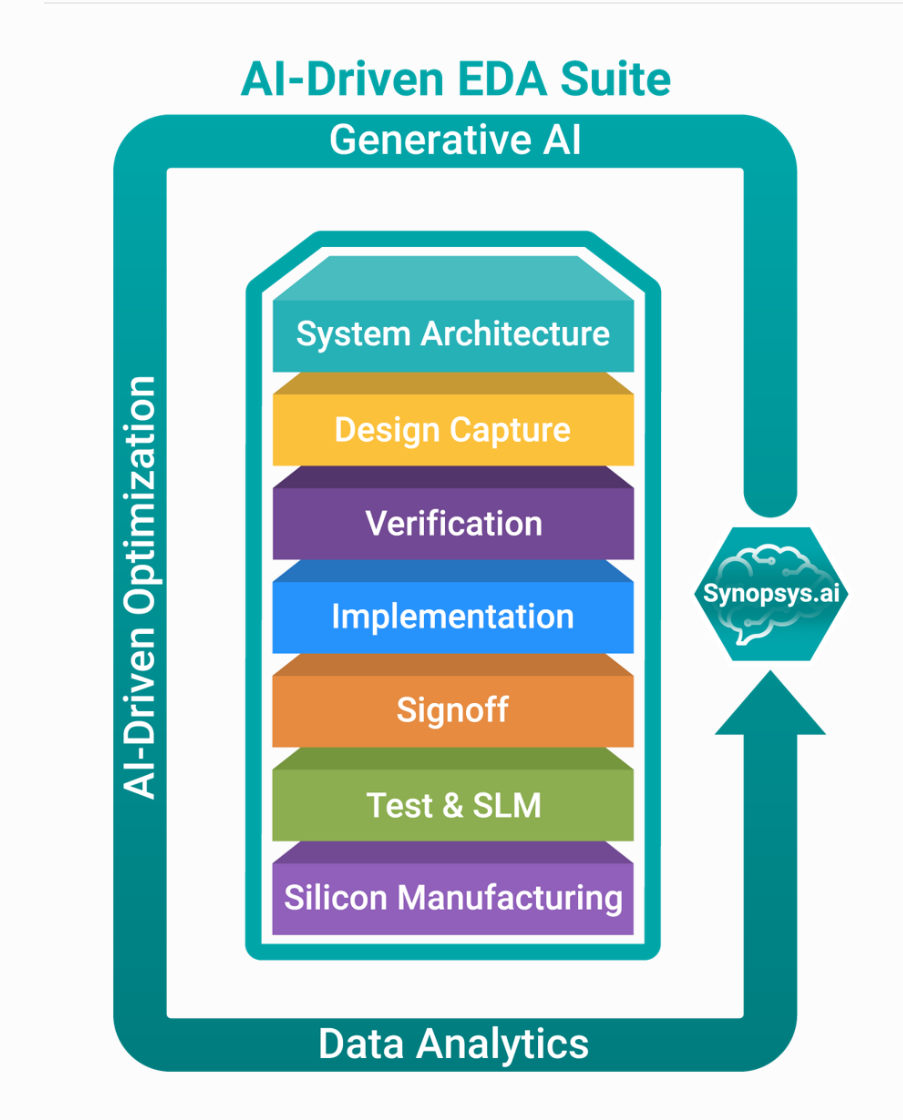

Synopsys的新CoPilot工具就是一个很好的例子。Synopsis.ai CopPilot于2023年11月发布,是业界首个用于芯片设计的GenAI。作为与微软Azure深入合作的产物,Synopsys.ai Copilot将Azure上的OpenAI生成式人工智能服务引入半导体设计。Synopsys.ai云服务专门托管在Azure上,两家公司在微软的Cobalt100和Maia 100AI加速器上有合作。

新的Synopsys Copilot是Synopsys与微软战略合作的成果,旨在整合Azure OpenAI服务,将GenAI的强大功能带入最复杂的工程挑战之一,即半导体设计。

微软工业云和全球扩展团队的商业副总裁科里·桑德斯(Corey Sanders)表示:“我们与Synopsys的合作建立在通过云端和人工智能加速半导体创新的共同愿景之上。微软的工程团队与Synopsys紧密合作,为EDA带来了生成式AI的变革力量,这将为使用Synopsys.ai Copilot的半导体设计工程师提供基于Microsoft Azure的最佳AI基础架构、模型和工具链。”

从Synopsys的网站上,可以看到这项意义深远的合作旨在提供以下服务:

人工智能驱动的全新体验:Synopsys.ai Copilot与设计人员一起使用他们日常使用的Synopsys工具,在整个设计团队中实现自然语言智能对话。

大规模人工智能基础架构:Synopsys.ai Copilot可在内部部署或云计算环境中部署,它集成了Microsoft Azure高性能计算基础架构,具有可用性、经济性和容量,可为高级芯片设计和验证应用处理AI工作负载。

安全负责的设计:双方合作的基础是共同关注构建安全可信、负责任的人工智能系统。该框架旨在促进人工智能技术的安全部署,以创建新的硅基应用。

Cadence

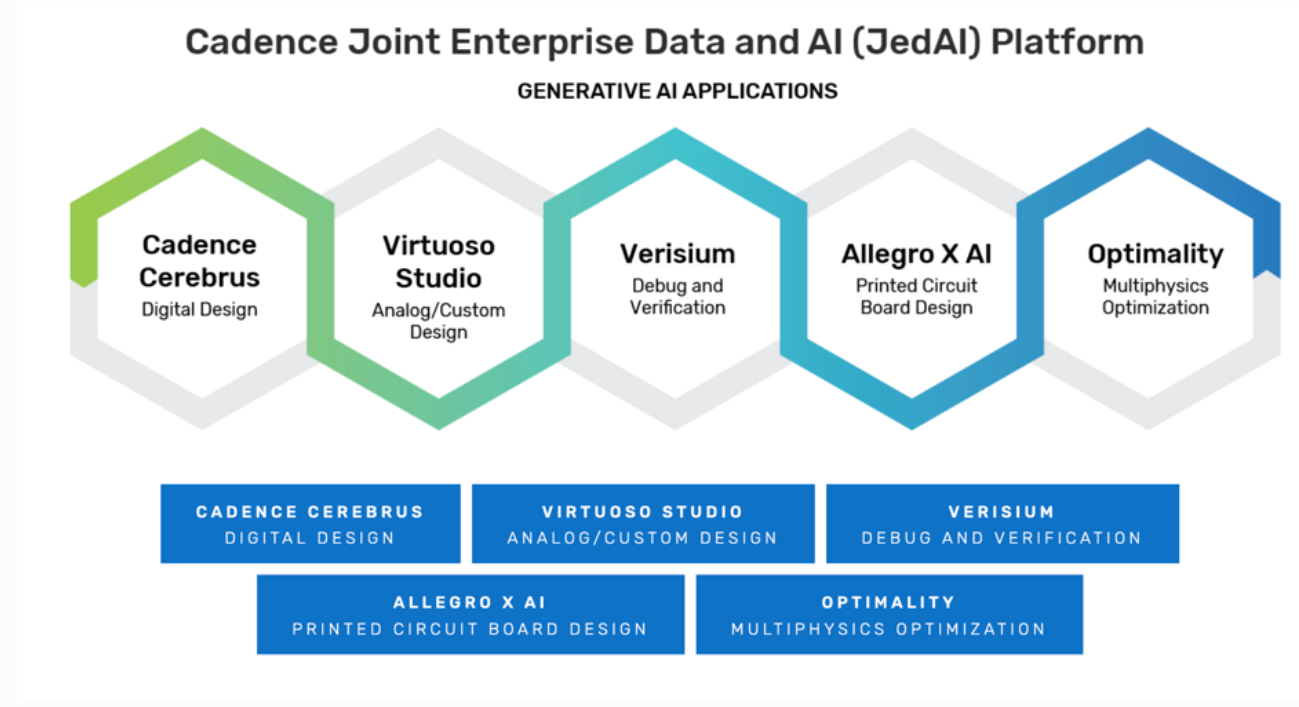

在过去的一年中,Cadence一直在构建和扩展其生成式人工智能产品组合,最近又宣布与瑞萨电子(Renasas)合作构建生成式人工智能,以提高半导体质量和设计团队的生产力。瑞萨电子高级副总裁兼CEO吉冈真一(Shinichi Yoshioka)表示,确保规范与设计之间的一致性至关重要,而验证成本随着设计功能的复杂性而增加。瑞萨电子与Cadence合作开发了一种新方法,利用生成式人工智能的LLM来应对这一挑战,通过有效控制设计质量,大大缩短了从规范到最终设计的时间。瑞萨电子也是Cadence Cerebrus芯片、Verisium人工智能驱动验证以及Cadence联合数据和人工智能(JedAI)平台的早期采用者,该平台通过设计和规则的通用数据库支撑整个设计流程。

用于EDA的内部人工智能

将人工智能应用于设计流程的一些创新来自谷歌和英伟达等超大规模公司和硬件设计公司。尽管Synopsys和Cadence等EDA供应商提供的工具非常出色,但它们并不能完全体现芯片团队积累的经验和专业知识。英伟达利用电子邮件、问题清单和其他数据建立了一个名为ChipNeMo的专有大语言模型,工程师无需向资历更深、经验更丰富的工程师寻求帮助。英伟达研究主管比尔·达利(Bill Dally)说:“事实证明,我们的资深设计师花了大量时间回答初级设计师提出的问题。如果这个工具可以节省了高级设计师的回答时间,那么这个工具就非常有意义。”

英伟达和亚马逊(AWS)近日宣布,他们正在建造一个新的超级计算机Project Ceiba,由16384颗GH200 Arm-GPU超级芯片组成。Ceiba将是世界上最快的图形处理器(GPU)驱动的人工智能超级计算机,这一超级计算机将专门用于英伟达工程团队创建新模型以及设计和测试新的GPU。显然,英伟达相信人工智能及其GPU在加速芯片路线图方面至关重要,英伟达已于今年早些时候宣布了这一流程。

何去何从?

在逻辑设计完成后的短短几个月内,EDA的各种人工智能模型最终将生产出速度更快、成本更低的芯片。工作流程的后半部分也将压缩。这将极大地改变和减少芯片设计人员的数量。工程师的工作将越来越多地集中在富有创造力的部分,以更高的薪酬创造新的设计逻辑,而不再是繁琐的重复性劳动。

可以看到这种变革正在实现。英伟达最近宣布,将把开发和发布新芯片的速度提高一倍。这并不是因为研发费用翻了一番,而是因为依靠人工智能缩短了设计周期。该公司已经建立了内部超级计算机,现在利用AWS托管服务供内部工程使用。Selene和Helios等系统为英伟达带来了竞争优势,并同时应用于LLM研究和芯片设计。